Aproveitando a introdução da Inteligência da Applea Maçã aproveitou para divulgar mais detalhes sobre seus dois modelos de IA generativa: o de linguagem no dispositivo (no dispositivo) e um maior, baseado no servidor com o Computação em nuvem privada.

Antes de mais nada, é importante frisar os quatro princípios da empresa na Apple Intelligence, sendo eles:

- A criação de ferramentas para que os usuários alcancem seus objetivos;

- A construção de produtos que evitam a perpetuação de estereótipos e visões sistêmicas em ferramentas e modelos de IA;

- Um cuidado para evitar que as ferramentas não sejam mal utilizadas ou levem a possíveis danos;

- Uma proteção à privacidade dos usuários — usando o processamento no próprio dispositivo e a infraestrutura do Private Cloud Compute.

Em um documento extensoa empresa descreve que o modelo que roda no dispositivo possui cerca de 3 bilhões de intervalosenquanto que o modelo de linguagem grande (LLM, na sigla em inglês) está hospedado em servidores da própria empresa, alimentados pela Apple Silicon.

O interessante é que a Maçã faz o treinamento usando dados licenciados, o que inclui informações selecionadas para aprimorar os recursos mais específicos e de dados disponíveis publicamente, coletados pelo rastreador da web AppleBot. Mesmo assim, ela frisa que os editores da web se quiserem poderão desabilitar o uso de seu conteúdo pela Apple Intelligence.

Como a Apple leva privacidade a sérioela deixa bem claro que nunca usa dados pessoais privados dos usuários, bem como interações feitas por eles — de forma que alguns filtros são aplicados a fim de que as informações mais pessoais sejam totalmente removidas.

Outro dado interessante apresentado no documento é que o tamanho do vocabulário no modelo de linguagem no dispositivo é de 49.000, enquanto que o modelo de servidor usa um tamanho de vocabulário de 100.000, incluindo a linguagem adicional e os fichas técnicos.

Com as otimizações feitas e usando um iPhone 15 Pro como exemplo, foi possível atingir uma latência de cerca de 0,6 milissegundo por símbolo de incitar e uma taxa de geração de 30 fichas por segundo.

Para testar os modelos, a Apple usou a referência Instruction-Following Eval (IFEval) para fazer uma comparação nas suas capacidades de entrega de instruções com modelos de tamanho de hardware.

Como você pode observar, os resultados sugerem que o modelo no dispositivo e no servidor da Maçã segue instruções descritas de uma maneira melhor do que os modelos de código aberto e comerciais.

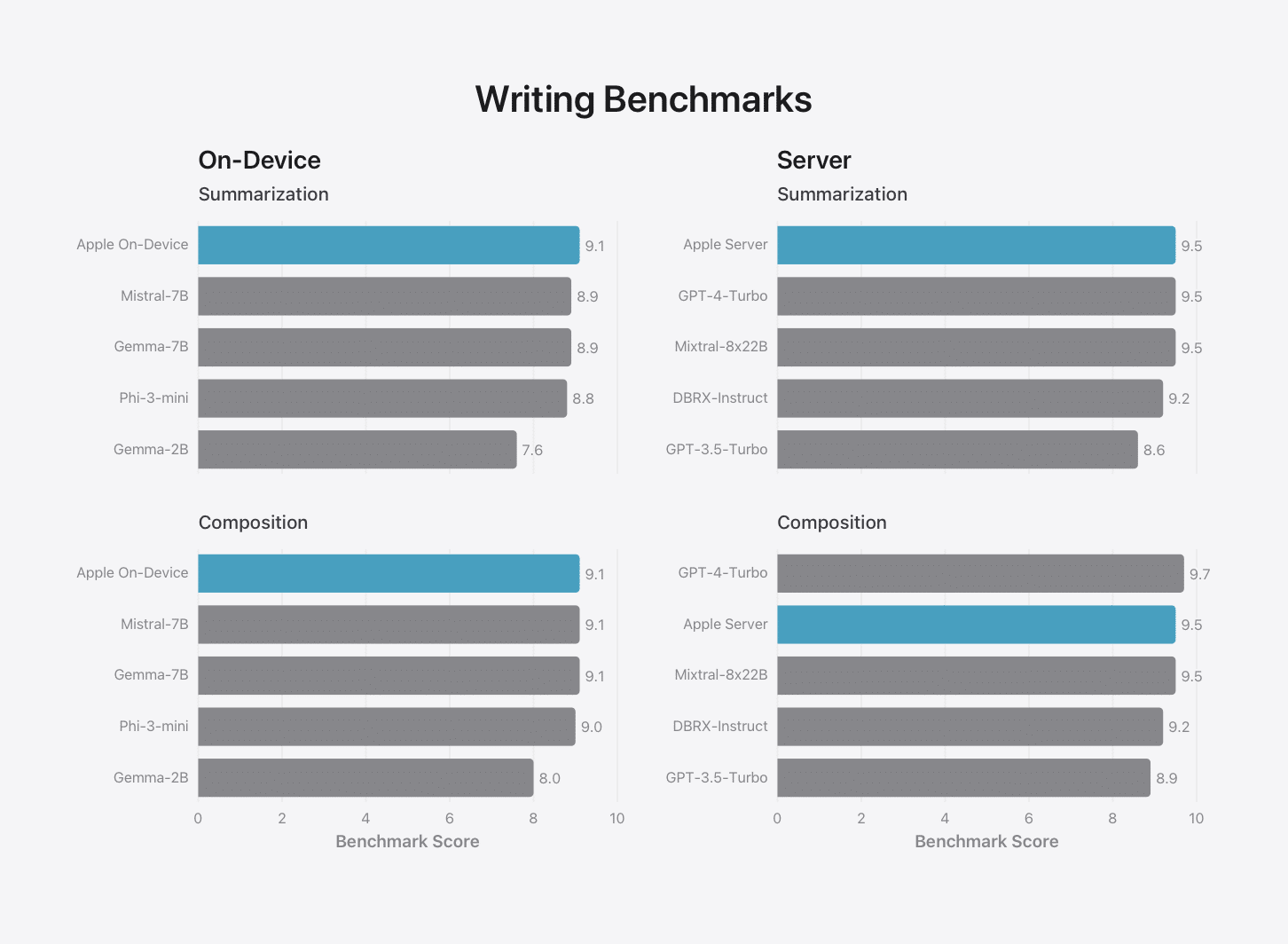

Em outro gráfico, uma comparação foi feita de maneira a avaliar a capacidade de escrita dos modelos da Apple em benchmarks internas de resumo e composição, consistindo em uma variedade de instruções de escrita.

Mais detalhes sobre os modelos de IA generativa da Apple podem ser conferidos nessa página.

através da MSPowerUser